En el amplio mundo del SEO existen múltiples conceptos que son clave y que, a priori, pueden resultar complejos de comprender. Un concepto importante que es necesario conocer y que es fundamental interpretar es el archivo robots.txt. Por ello, a lo largo de este artículo te voy a explicar qué es el archivo robots.txt, qué usos tiene y cómo debe interpretarse correctamente.

Qué es el archivo robots.txt

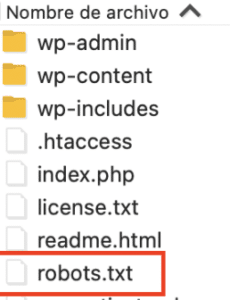

El archivo robots.txt es un fichero a través del cual le indicamos a los buscadores qué secciones de un proyecto debe rastrear y cuáles no. Se trata de un fichero que debe incluirse en la raíz del servidor y que, a través de diferentes directivas que veremos más adelante, ayuda a los motores de búsqueda a optimizar el rastreo de un sitio web.

Cuál es la finalidad del archivo robots.txt

Como he comentado, la principal función del archivo robots.txt es facilitar el trabajo a los crawlers. De esta forma, cuando Googlebot proceda a rastrear nuestro sitio web ya tendrá ciertas pautas a tener en cuenta para realizar este proceso.

Es importante tener en cuenta que las directivas que proporcionamos en el archivo robots.txt son recomendaciones y no ordenes estrictas. Por tanto, los crawlers pueden tenerlas en cuenta o no.

Así pues, se puede determinar que la finalidad de implementar este archivo es optimizar el presupuesto de rastreo evitando que los motores de búsqueda desperdicien recursos rastreando aquellas URL del sitio web que no interesa posicionar. Como ya sabemos, uno de los principales objetivos en cualquier estrategia SEO es optimizar tanto el rastreo como la indexación.

Cómo se configura un archivo robots.txt

La configuración del archivo robots.txt no tiene gran complejidad. Será necesario abrir un editor de texto, como el bloc de notas, y comenzar a incluir la información necesaria para nuestro proyecto.

Hay que tener en cuenta que existen diferentes plugins SEO que ya integran automáticamente esta función. Por ejemplo, Yoast SEO, el plugin para optimización SEO por excelencia de WordPress, incluye de forma predeterminada la creación del robots.txt.

Qué información se debe proporcionar en el archivo robots.txt

Tal y como he comentado, la información recogida en este fichero podrá ser tanto restrictiva como permisiva. A continuación, explico las principales directivas que existen a la hora de incluir las directrices.

User-agent

A través de esta directiva, especificaremos a qué crawlers en concreto queremos dirigir las directrices. En caso de que no queramos hacer distinción, sería suficiente con que asignemos un asterisco (*).

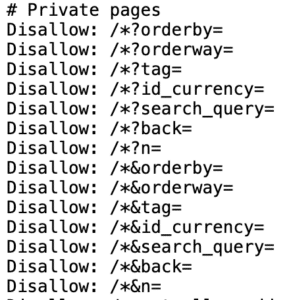

Disallow

La directiva “disallow” tiene un carácter restrictivo. Con esta directiva lo que le estamos diciendo a los motores de búsqueda es que no rastreen el directorio, la ruta o la URL específica que le asignemos. Esta directiva es muy común en aquellos ecommerce que cuentan con cantidades ingentes de URL. Es una forma de optimizar el rastreo, ya que así se puede bloquear el rastreo de cualquier URL parametrizada, entre muchas otras aplicaciones.

Allow

Esta directiva tiene carácter permisivo. Le transmite a Googlebot que debe rastrear todo lo que se le asigne en esa línea específica del fichero.

Cómo es la sintaxis del robots.txt

Llegados a este punto, es importante conocer la sintaxis del archivo robots.txt. Es importante asegurarse de que las directivas estén formateadas de manera adecuada para que los crawlers las puedan interpretar correctamente. A continuación, dejo un ejemplo de cómo podría verse:

User-agent: *

Disallow: /paginas-restringidas/

Allow: /paginas-permitidas/Aspectos técnicos del robots.txt

El archivo robots.txt puede ser más que una simple lista de directivas. Puede incorporar algunos aspectos técnicos que permiten un mayor control sobre el rastreo de los motores de búsqueda.

El uso de «$» (Dólar)

El símbolo «$» en la inclusión de URLs en el archivo robots.txt se utiliza como un modificador especial para indicar una coincidencia exacta en la URL. Esto significa que cuando se coloca «$» al final de una directiva «Allow» o «Disallow» junto con una URL, se especifica que esa regla se aplicará solo a la URL exacta que coincide con la ruta especificada, sin incluir ninguna variante o subdirectorio.

Supongamos que deseas permitir que un motor de búsqueda rastree solo la página específica «https://www.tuweb.com/ejemplo» y no todas las páginas que contienen «ejemplo» en su ruta. Para lograr esto, puedes usar el símbolo «$» de la siguiente manera en tu archivo robots.txt:

User-agent: *

Disallow: /ejemplo$En este caso, la directiva «Disallow» con «$» al final indica que los motores de búsqueda no deben rastrear ninguna URL que termine exactamente con «/ejemplo». Esto significa que «https://www.tuweb.com/ejemplo» será excluida, pero otras URL como «https://www.tuweb.com/pagina-ejemplo» no se verán afectadas por esta directiva.

El uso del símbolo «$» es útil cuando deseas controlar con precisión qué páginas deben o no deben rastrearse en función de rutas URL específicas y evitar que reglas más generales afecten a URLs que puedan coincidir parcialmente con la directiva. Sin embargo, ten en cuenta que no todos los motores de búsqueda pueden admitir el símbolo «$», por lo que es importante verificar su compatibilidad antes de implementarlo en tu archivo robots.txt.

El asterisco (*) como comodín

El asterisco es un comodín que se utiliza en el archivo robots.txt para representar cualquier valor. Por ejemplo, si deseas bloquear el acceso a todas las URL que contienen una palabra específica en su ruta, puedes utilizar el asterisco de la siguiente manera:

User-agent: *

Disallow: /*palabra*Esta directiva evitará el acceso a todas las URL que contienen «palabra» en su ruta, independientemente del nombre del agente de usuario.

Uso de comandos especiales

Algunos robots de búsqueda admiten comandos especiales en el archivo robots.txt para tareas avanzadas. Uno de los comandos más conocidos es «Crawl-delay» que permite controlar la velocidad de rastreo de un robot específico. Por ejemplo:

User-agent: Googlebot

Crawl-delay: 5En este caso, el comando «Crawl-delay» instruye a Googlebot a rastrear el sitio a una velocidad más lenta, lo que puede ser útil para evitar una carga excesiva en el servidor.

Buenas prácticas a la hora de configurar el robots.txt

Además de los aspectos básicos que deben tenerse en cuenta a la hora de configurar el robots.txt, existen diferentes buenas prácticas que también deberían llevarse a cabo en este punto.

Una de ellas es la inclusión del sitemap.xml del sitio web en el mismo. En caso de que se trate de proyectos de poca magnitud esto puede ser menos relevante, ya que trabajando correctamente el enlazado interno, los motores de búsqueda deberían poder seguir los enlaces y rastrear e indexar todo el contenido del sitio sin ningún problema.

Realmente, tiene más utilidad incluir el sitemap en sitios web de gran calibre que cuentan con infinidad de URL. Dado que puede ser que el enlazado interno sea más complejo de trabajar, incluir el sitemap.xml en el archivo robots.txt facilitará a los motores de búsqueda la interpretación de cuáles son aquellas URL que realmente deberían ser indexadas.

Recomendaciones finales

Por último, es recomendable realizar diferentes pruebas antes de subir al servidor la versión definitiva del archivo robots.txt. Para ello, existen diferentes herramientas como robots.txt validator and testing tool que nos permitirá chequear el rastreo de URLs específicas en función de nuestra configuración del robots.txt.

En definitiva, ya hemos visto qué es el archivo robots.txt, qué finalidad tiene y diferentes conceptos relacionados a este término y su correcta interpretación. Ahora solo queda que pongas en práctica lo aprendido en este artículo y optimices el rastreo de tu sitio web.